¶ 1. Visão Geral

O Client Gateway é um executável criado pela T6 Enterprise para ser instalado no ambiente do cliente. E é através dele que tarefas de cargas de dados remotos são possíveis. Ele funciona como um intermediário entre cliente e servidor, buscando dados de acordo com a configuração fornecida pelo servidor e devolvendo os dados solicitados.

¶ 2. Instalação

O Client Gateway está disponível para o sistema operacional Windows e Linux. Instale-o de acordo com o seu sistema operacional. Não há necessidade de instalar outros pacotes como requisitos.

O Client Gateway é uma aplicação que ficará rodando em segundo plano no terminal. Para encerrar a aplicação basta alternar para a janela onde ela está rodando e enviar o comando CRTL+C.

¶ 2.1. Pré-Requisitos

Antes de iniciar a instalação é necessário baixar o arquivo do Client Gateway de acordo com o seu sistema operacional Linux ou Windows. Porém é necessário que o SO contenha uma das cifras de TLS 1.2 ou 1.3 utilizadas pelo T6 Planning:

Para o correto funcionamento do ClientGateway para v12.0, é necessário a instalação do .NET Core 8.0 Runtime & Hosting Bundle for Windows (v8.0.0). Para mais informações sobre os pré requisitos da versão 12.0 acesse Guia de Instalação - v12.0.

Client Gateway para versão v11.11:

Client Gateway para versão v12.0:

Client Gateway para versão v12.1:

TLS 1.2:

- TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256 (0xc02f) ECDH x25519 (eq. 3072 bits RSA) FS;

- TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384 (0xc030) ECDH x25519 (eq. 3072 bits RSA) FS;

- TLS_ECDHE_RSA_WITH_CHACHA20_POLY1305_SHA256 (0xcca8) ECDH x25519 (eq. 3072 bits RSA) FS.

TLS 1.3:

- TLS_AES_256_GCM_SHA384 (0x1302) ECDH x25519 (eq. 3072 bits RSA) FS;

- TLS_CHACHA20_POLY1305_SHA256 (0x1303) ECDH x25519 (eq. 3072 bits RSA) FS;

- TLS_AES_128_GCM_SHA256 (0x1301) ECDH x25519 (eq. 3072 bits RSA) FS.

É necessário efetuar a liberação de firewall referente a porta 443.

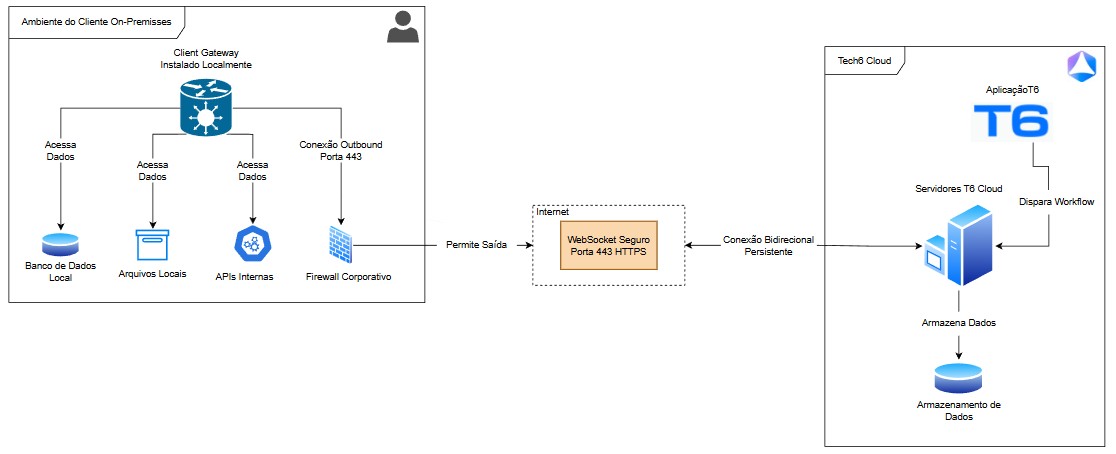

¶ 3. Funcionamento Técnico do Client Gateway

O Client Gateway da T6Cloud foi desenvolvido para facilitar a integração segura entre seu ambiente local e a nuvem, sem complicações de infraestrutura. Utilizamos a tecnologia WebSocket para estabelecer uma comunicação bidirecional moderna e eficiente, que simplifica drasticamente a configuração necessária em sua rede.

Utilizamos o WebSocket porque, diferentemente de métodos tradicionais que exigem abertura de portas no firewall, configuração de VPN ou tunelamento reverso, o WebSocket permite que o Client Gateway inicie a conexão de dentro da sua rede para fora.

Na prática, isso significa:

- Zero configuração complexa de firewall: Não é necessário abrir portas de entrada (inbound) na sua rede;

- Sem VPN: A comunicação é estabelecida de forma direta e segura;

- Compatível com proxies corporativos: Funciona mesmo em ambientes de rede restritivos.

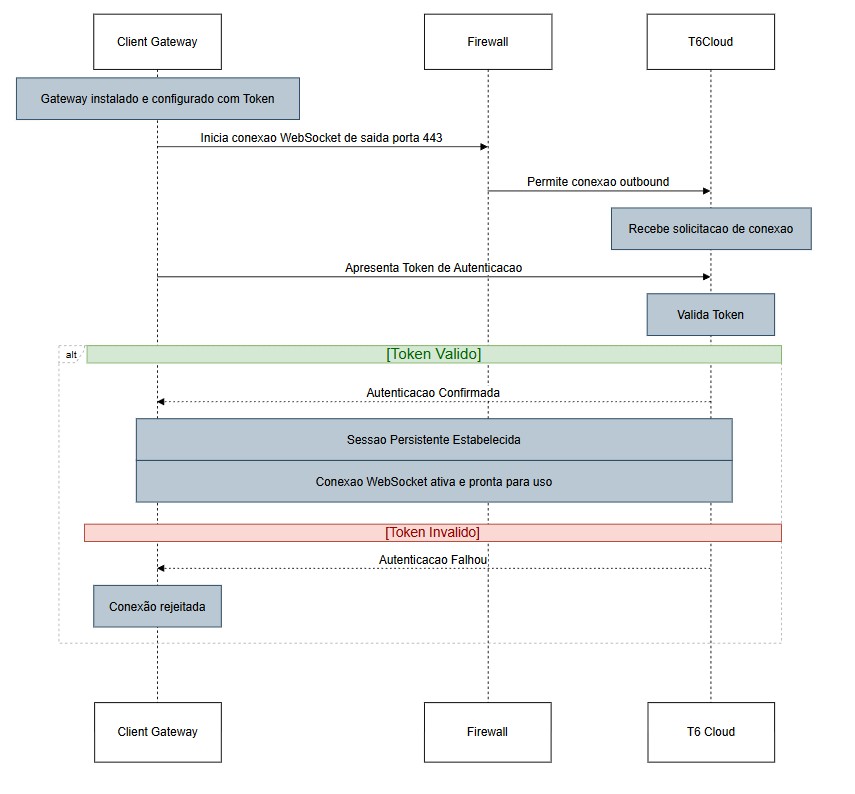

Quando você instala o Client Gateway no seu servidor local e o configura com o token de ativação, o gateway estabelece automaticamente uma conexão WebSocket de saída (outbound) com os servidores da T6Cloud. Essa conexão usa a porta 443 (HTTPS), a mesma utilizada para navegação web segura. Por ser uma conexão de saída, ela passa normalmente pela maioria dos firewalls corporativos.

Assim que a conexão é estabelecida:

- O gateway apresenta seu token único de autenticação à T6Cloud;

- A T6Cloud valida o token e confirma a identidade do gateway;

- Ambos estabelecem uma sessão persistente e confiável;

- A partir deste momento, a conexão permanece "viva" e pronta para uso.

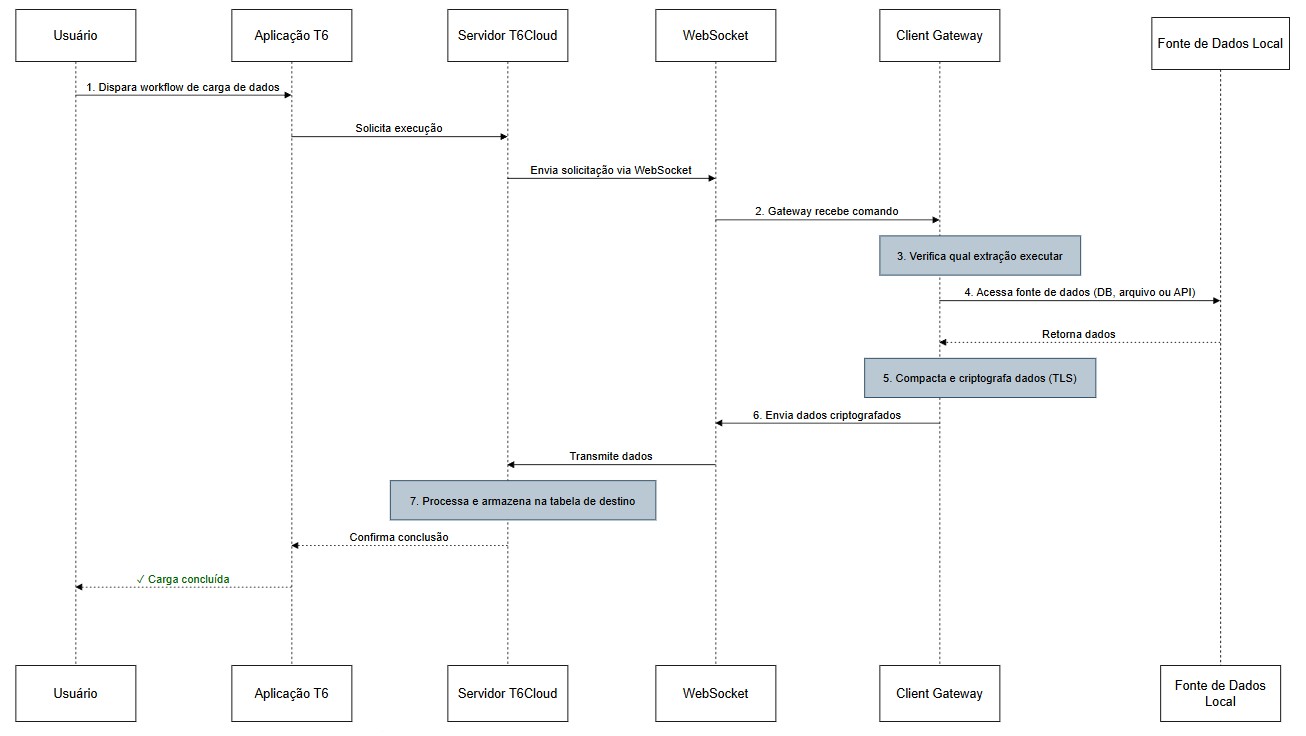

¶ 3.1 Execução de Cargas de Dados (Sob Demanda)

Quando você dispara um workflow de carga de dados no portal da T6Cloud:

- A T6Cloud envia uma solicitação através da conexão WebSocket para o gateway;

- O gateway recebe o comando e verifica qual extração deve executar;

- O gateway acessa localmente seu banco de dados, arquivo ou API conforme configurado;

- Os dados extraídos são compactados e criptografados automaticamente utilizando TLS (Transport Layer Security);

- O gateway envia os dados de volta para a T6Cloud através da mesma conexão WebSocket;

- A T6Cloud processa e armazena os dados na tabela de destino configurada.

¶ 3.2 Modelo "Pull" de Segurança

O Client Gateway opera no modelo pull (puxar dados quando solicitado), não push:

- Não há tráfego espontâneo: O gateway só age quando recebe uma solicitação legítima da T6Cloud;

- Você mantém o controle: A conexão é sempre iniciada pelo seu ambiente;

- Segurança por design: Ninguém de fora consegue "empurrar" dados ou comandos para dentro da sua rede.

¶ 3.3 Pré-Requisitos Técnicos do Lado do Cliente

Para garantir o funcionamento adequado do Client Gateway, seu ambiente precisa atender aos seguintes requisitos:

Requisitos de Sistema

Sistema Operacional

- Windows: Windows Server 2012 R2 (ou superior) / Windows 10 (ou superior);

- Linux: Distribuições modernas com suporte a .NET Core 8.0.

.NET Runtime

- .NET Core 8.0 Runtime & Hosting Bundle;

- O gateway não requer instalação de banco de dados ou servidores web adicionais.

Permissões de Acesso

- Acesso de leitura aos bancos de dados ou arquivos que serão extraídos;

- Permissão para executar o gateway como serviço (recomendado para produção).

Requisitos de Configuração

Token de Ativação

- Obtido no portal T6Cloud ao criar um objeto Carga de Dados Remota, necessário para autenticação e vinculação do gateway à sua aplicação.

Credenciais de Acesso às Fontes de Dados

- Usuário e senha para acesso aos bancos de dados locais;

- Strings de conexão corretamente configuradas no arquivo

appsettings.json.

¶ 3.4 Vantagens para Sua Infraestrutura

Segurança Máxima

- Todos os dados trafegam criptografados de ponta a ponta;

- Sem exposição de portas ou serviços internos;

- Autenticação por token único e intransferível.

Performance Otimizada

- Compactação automática dos dados antes do envio;

- Conexão persistente reduz latência;

- Transmissão eficiente mesmo com grandes volumes.

Importante: Todo o tráfego é iniciado pelo Client Gateway em direção à T6Cloud. Isso significa que nenhuma conexão externa tenta acessar sua rede, garantindo máxima segurança e conformidade com políticas de TI corporativas.

¶ 4. Configuração

Na pasta descompactada, onde encontram-se os arquivos do Client Gateway, procure pelo arquivo appsettings.json. Abra-o em um editor de texto, de preferência um editor que lê arquivos json.

Abaixo segue uma imagem enquadrando todos os parâmetros que constam atualmente no Client Gateway, baseando-se na versão que foi usada neste manual.

{

"DataLoadGatewayConfig": {

"LogFile": "ppGateway.log",

"HealthFile": "ppHealth.log",

"HealthInterval": 20,

"Url": "http://localhost/Sysphera/dataloadhub",

"Key": "",

"Issuer": "https://sysphera.com/dataloadhub/issuer",

"Audience": "https://sysphera.com/dataloadhub/audience",

"ClientId": "",

"DataSources": [

{

"DataSourceName": "",

"DataSourceType": "",

"StringConnection": ""

},

]

}

}

Sempre que for utilizar o Client Gateway faça a verificação do

appsettings.json, principalmente quando houver troca de versões do Gateway

Descrição dos parâmetros:

- LogFile: Informe aqui um nome para o arquivo de log. Neste arquivo ficará registrado informações recorrentes ao Client Gateway;

- HealthFile: Informe aqui o nome do arquivo que será utilizado para o health check (realiza verificações regulares de segurança, desempenho e integridade dos dados);

Tanto o

LogFilequanto oHealthFileaceitam caminhos completos onde espera-se que os arquivos sejam salvos. Porém, caminhos relativos também são aceitos e neste caso será considerado a pasta de onde o Client Gateway foi chamado para formar o caminho absoluto.

- HealthInterval: Intervalo entre checagens do health check. Parâmetro opcional com valor padrão de 20 (minutos).

- Url: Informe aqui a URL da aplicação T6, finalizando com

/dataloadhub/. Esse parâmetro informa onde está localizado a parte que está no servidor, com a qual o Client Gateway irá se comunicar.

Temos 3 parâmetros que não necessitam de alteração:

- Key: o valor dessa chave será fornecido pela equipe de implantação;

- Issuer: https://Sysphera.com/dataloadhub/issuer;

- Audience: https://Sysphera.com/dataloadhub/audience;

Para os próximos parâmetros precisaremos acessar o T6 e criar um objeto do tipo Carga de Dados Remota.

- ClientId: Vamos inserir o código gerado ao salvar o objeto do tipo Carga de Dados Remota;

- DataSources: Cada datasource possui 3 informações que precisam ser preenchidas de acordo com os valores usados na criação da Carga de Dados Remota. São elas:

- DataSourceName: ” ” (É o nome da base de dados que temos no banco de dados.)

- DataSourceType: “ ” (É o nome adicionado na criação da Carga de Dados)

- StringConnection: ” ” (Podemos obter referências de connectionstring no site https://www.connectionstrings.com/)

Podemos ter vários datasources. Basta adicionarmos no arquivo respeitando a formatação do JSON.

Podemos nos conectar através de SQLserver, Oracle, CosmosDB, REST, MySQL, Postgree e ODBC.

Para conseguirmos os dados para o preenchimento dos parâmetros citados acima, precisaremos seguir os seguintes passos:

- Após logar no T6, vá até o menu principal e acesse Explorer;

- Na página do explorer, na ribbon, clique em Novo Item;

- Clique em Carga de Dados e selecione Carga de Dados Remota;

- Um novo objeto será criado, ao abrir o objeto criado, um panel na lateral será exibido, onde teremos Código e Fontes;

- Código: Estará exibindo

00000000-0000-0000-0000-000000000000pois nenhum datasource foi salvo; - Fontes: Exibe a listagem de fontes adicionadas ao objeto;

- Código: Estará exibindo

- Um novo objeto será criado, ao abrir o objeto criado, um panel na lateral será exibido, onde teremos Código e Fontes;

- No panel, ao lado de Fontes, vamos clicar em

;

; - Será exibido um formulário onde iremos preencher: Nome, Usuário, Senha e Intervalo

- Nome: É o nome da base de dados no banco de dados, que iremos adicionar no parâmetro

DataSourceNamedo arquivoappsettings.json - Usuário: É o nome de usuário que acessa o banco de dados e que iremos adicionar no parâmetro

StringConnectiondo arquivoappsettings.json; - Senha: É a senha de usuário que acessa o banco de dados e que iremos adicionar no parâmetro

StringConnectiondo arquivoappsettings.json; - Intervalo: Podemos definir o tempo de espera, em segundos, para a carga de dados ser concluída (valor padrão 0);

- Nome: É o nome da base de dados no banco de dados, que iremos adicionar no parâmetro

- Após preencher os dados, vamos clicar em Confirmar, iremos voltar para a página inicial do panel;

- De volta ao panel da carga de dados remota, o código continuará zerado e teremos a fonte criada sendo exibida;

- Ao clicarmos em Salvar, o panel será fechado. Abra o objeto novamente para voltar a abrir o panel;

- Ao abrir o objeto após salvarmos, o código terá sido gerado, para copiá-lo podemos clicar em:

Vamos atribuir estes valores aos parâmetros mencionados, segue abaixo um exemplo com os datasources do tipo SQLSERVER, ORACLE, POSTGRE, MySQL, CosmosDB e DATALOADREST:

"ClientId": "A1A1A1A1-B2B2-C3C3-D4D4-E5E5E5E5E5E5",

"DataSources": [

{

"DataSourceName": "SQLServer",

"DataSourceType": "SQLSERVER",

"StringConnection": "Data Source=SQLServerConnection;Initial Catalog=DataBaseName;Trusted_Connection=false;Persist Security Info=True;User ID=User;Password=pwd"

},

{

"DataSourceName": "Oracle",

"DataSourceType": "ORACLE",

"StringConnection": "Data Source=OracleConnection;User ID=user;Password=pwd"

},

{

"DataSourceName": "PostgreSQL",

"DataSourceType": "POSTGRESQL",

"StringConnection": "Server=host.docker.internal;Port=5432;Database=mydb;User Id=user;Password=pwd;"

},

{

"DataSourceName": "MySQL",

"DataSourceType": "MYSQL",

"StringConnection": "Server=host.docker.internal;Database=myDataBase;Uid=user;Pwd=pwd;"

},

{

"DataSourceName": "CosmosDB",

"DataSourceType": "COSMOSDB",

"StringConnection": "AccountEndpoint=https://cosmodb-example.documents.azure.com:443/;AccountKey=bpuRR4tLLQO6M2RB1Jop1KBJbByDm1zLGp2LJHeZJLaSSkft5aCApY9T2tUKx9qg591XyaSLZ0hRDDiACDb44k1vkA==",

"Configuration": {

"Database": "SampleDB",

"Container": "SampleContainer"

}

},

{

"DataSourceName": "Data Load Rest",

"DataSourceType": "DATALOADREST"

}

]

No caso do CosmosDB a própria engine do Azure fornece a ConnectionString, sendo ela uma junção da sua URL com o campo Primary Key (ou Second Key) exibidos na aba Keys do seu portal Azure. Temos também o campo Configuration, que não é solicitado em outros datasources, os dados para preenchimento deste campo são o nome do Database criado no portal do Azure e o nome do Container utilizado.

- Para Configurar o CosmosDB no T6, as configurações permanecem as mesmas, sendo necessário a inserção somente do campo Nome (o mesmo configurado no parâmetro DataSourceName);

¶ 4.1. Carga de dados remota com CosmosDB

Utilizando a carga de dados remota em uma conexão com um banco de dados NoSQL (CosmosDB), podemos garantir a existência de uma coluna, mesmo que sem dados:

Para visualizar, vamos criar um processo do Workflow:

- Crie um objeto do Workflow e adicione uma tarefa;

- Vamos inserir um nome qualquer para a tarefa;

- Em tipo da tarefa, vamos selecionar Carga de Dados Remota e clicar em próximo;

- Em Carga de Dados Remota, vamos selecionar o objeto de carga de dados remota criado anteriormente (CosmosDB);

- Em Comando SQL, vamos inserir a chamada SQL que desejamos executar, por exemplo:

SELECT

Container.ID AS itemId, Container.price, Container.tags, Container.custom ? (Container.custom): null AS custom

FROM Container;

Esta sintaxe, fará a consulta no banco e irá trazer uma coluna chamada "custom", ela existindo no banco ou não, caso exista e contenha dados, os mesmos serão retornados, caso não contenha, a coluna irá retornar com valor "null".

- Em Destino, vamos selecionar Novo;

- Quando selecionamos Novo em destino e o processo funciona, é criada a Tabela de Dados de acordo com o metadado;

- Vamos clicar em Finalizar, será criada uma Tabela de Dados com o nome da conexão criada no objeto de carga de dados remota;

Podemos selecionar em Destino uma tabela de dados já constante em nosso sistema, porém é necessário que o número de colunas e o nome em seus cabeçalhos sejam iguais ao da tabela de origem;

Podemos marcar a checkbox Reestruturar tabela de dados automaticamente que fará o ajuste automático da tabela de destino, sem a necessidade de ter o mesmo número e nome de colunas da tabela de origem;

- Vamos salvar e publicar o processo do workflow;

¶ 5 Client Gateway via Docker

Primeiramente é necessário prepararmos um container para o gateway;

- Abra um terminal a partir da pasta

srcdo projeto PowerPlaning cd C:...\powerplaning\src;

- Precisaremos utilizar uma imagem pública do gateway, podemos conseguir através de um repositório de imagens Docker, ou através do DockerHub;

- Vamos selecionar a imagem dentro do repositório (para fins de exemplo vamos nomeá-la como

ImagemPublica/ClientGateway:latest); - Dentro do terminal vamos executar o comando docker pull ImagemPublica/ClientGateway:latest para baixar a imagem pública do DockerHub;

Substitua

ImagemPublica/ClientGateway:latestpelo nome correto da imagem pública que você está utilizando.

- Copiar o arquivo

.envde exemplo cp ClientGateway/.env.sample ./;- Este comando irá copiar o conteúdo do projeto ClientGateway/.env.sample e jogar para a pasta

src;

- Este comando irá copiar o conteúdo do projeto ClientGateway/.env.sample e jogar para a pasta

- editar o arquivo

.env.samplecom as suas configurações code .env.sample;

O clientID é obtido através do T6, quando criamos um objeto do tipo "Carga de Dados Remota", ao abrí-lo, teremos um código que deverá ser inserido na parte de configuração

DataLoadGatewayConfig__ClienId=********-****-****-****-***********;

- Executar o Gateway via Docker

docker run --env-file .env.sample --name ClientGateway -d ImagemPublica/ClientGateway:latest

- Dentro do T6, vamos abrir um objeto do tipo Carga de Dados Remota, será aberto um panel na lateral, onde iremos clicar em Adicionar;

- Será necessário informar Nome, Usuário e Senha;

- Ainda dentro do T6, iremos criar um processo do Workflow;

- Vamos adicionar uma tarefa ao processo do workflow, neste exemplo vamos nomeá-la como Load Postgres, do tipo Carga de Dados Remota;

- Vamos clicar em Próximo;

- Em Carga de dados Remota, vamos selecionar selecionar Postgres;

- Em Comando SQL vamos inserir: SELECT * FROM employee ("employee" é o nome de uma tabela dentro do banco de dados);

- Em Destino vamos selecionar "Novo"

Será criada dentro do T6 uma Tabela de Dados com o nome da conexão criada no objeto Carga de Dados Remota Load Postgres;

Podemos marcar a checkbox Reestruturar tabela de dados automaticamente que fará o ajuste automático da tabela de destino, sem a necessidade de ter o mesmo número e nome de colunas da tabela de origem;

- Vamos criar um gatilho para execução do processo do workflow;

- Vamos executar o gatilho;

- Após a execução do gatilho, vamos criar um Formulário de Dados, fazendo link com a Tabela de Dados criada;

Ao adicionarmos dados à tabela de forma externa (através do banco de dados) e executarmos o gatilho novamente essas alterações serão refletidas na tabela de dados criada no T6.

¶ 6. Conectando Client Gateway com MSSQL (ODBC)

- Vamos configurar nosso Client Gateway acessando o arquivo

appsettings.jsondentro da pasta ClientGateway;

Na configuração temos 2 parâmetros principais que devemos dar atenção:

- URL: Necessariamente deverá conter o endpoint /dataloadhub

- ClientID: É o código gerado ao salvarmos o objeto do tipo Carga de Dados Remota no T6;

- Vamos criar uma fonte de dados ODBC para conectar ao MSSQL, dentro do

appsettings.jsonvamos inserir mais um bloco de informações

{

"DataSourceName": "ODBC MSSQL",

"DataSourceType": "ODBC",

"StringConnection": "Driver={ODBC Driver 17 for SQL Server};Server=myServerAddress;Database=myDataBase;UID=myUsername;PWD=myPassword;"

}

- Para rodar o ClientGateway novamente vamos executar o comando dotnet run;

Após configurado, vamos voltar ao T6, onde iremos criar um Processo do Workflow para podermos visualizar o funcionamento.

- Crie um objeto do Workflow e adicione uma tarefa;

- Vamos inserir um nome qualquer para a tarefa;

- Em tipo da tarefa, vamos selecionar Carga de Dados Remota e clicar em próximo;

- Em Carga de Dados Remota, vamos selecionar o objeto de carga de dados remota criado anteriormente;

- Em Comando SQL, vamos inserir a chamada SQL que desejamos executar, por exemplo SELECT * FROM REP_APPLICATION;

- Em Destino, vamos selecionar Novo;

- Quando selecionamos Novo em destino e o processo funciona, é criada a Tabela de Dados de acordo com o metadado;

- Vamos clicar em Finalizar, será criada uma Tabela de Dados com o nome da conexão criada no objeto de carga de dados remota;

Podemos selecionar em Destino uma tabela de dados já constante em nosso sistema, porém é necessário que o número de colunas e o nome em seus cabeçalhos sejam iguais ao da tabela de origem;

Podemos marcar a checkbox Reestruturar tabela de dados automaticamente que fará o ajuste automático da tabela de destino, sem a necessidade de ter o mesmo número e nome de colunas da tabela de origem;

- Vamos salvar e publicar o processo do workflow;

- Iremos retornar ao explorer e criar um Gatilho do Workflow, onde iremos selecionar o processo criado e executar o gatilho;

- De volta ao explorar, agora vamos criar um Formulário de Dados;

- Ao abrir o formulário, vamos vincular a tabela de dados criada, selecionar as linhas e colunas que serão exibidas e salvar o formulário;

- Após feito isso, vamos retornar ao explorar e abrir o formulário de dados criado;

- Ao abrirmos o formulário, serão exibidas as linhas e colunas selecionadas, constantes no banco de dados MSSQL trazidas via ODBC;

¶ 7. Conectando Client Gateway com Excel (ODBC)

Vamos criar um objeto no T6 do tipo Carga de Dados Remota (ou, adicionar mais uma conexão caso já tenha um objeto deste tipo);

- Vamos configurar nosso Client Gateway acessando o arquivo

appsettings.jsondentro da pasta ClientGateway; - Vamos criar uma fonte de dados ODBC para conectar ao Excel, dentro do

appsettings.jsonvamos inserir mais um bloco de informações

{

"DataSourceName": "ODBC EXCEL",

"DataSourceType": "ODBC",

"StringConnection": "Driver={Microsoft Excel Driver (*.xls, *.xlsx, *.xlsm, *.xlsb)};DBQ=C:\\MyExcel.xls;"

}

Em StringConnection, DBQ é o local onde o arquivo do Excel está salvo

- Para rodar o ClientGateway novamente vamos executar o comando dotnet run;

Após configurado, vamos voltar ao T6, onde iremos criar um Processo do Workflow para podermos visualizar o funcionamento.

- Crie um objeto do Workflow e adicione uma tarefa;

- Vamos inserir um nome qualquer para a tarefa;

- Em tipo da tarefa, vamos selecionar Carga de Dados Remota e clicar em próximo;

- Em Carga de Dados Remota, vamos selecionar o objeto de carga de dados remota criado anteriormente;

- Em Comando SQL, vamos inserir a chamada SQL que desejamos executar, por exemplo SELECT * FROM [Sheet1$];

- Sheet1 é a tabela do arquivo Excel. $ é colocado para informar o driver que se trata de uma tabela.

- Em Destino, vamos selecionar Novo;

- Quando selecionamos Novo em destino e o processo funciona, é criada a Tabela de Dados de acordo com o metadado;

- Vamos clicar em Finalizar, será criada uma Tabela de Dados com o nome da conexão criada no objeto de carga de dados remota;

- Vamos salvar e publicar o processo do workflow;

- Iremos retornar ao explorer e criar um Gatilho do Workflow, onde iremos selecionar o processo criado e executar o gatilho;

- De volta ao explorar, agora vamos criar um Formulário de Dados;

- Ao abrir o formulário, vamos vincular a tabela de dados criada, selecionar as linhas e colunas que serão exibidas e salvar o formulário;

- Após feito isso, vamos retornar ao explorar e abrir o formulário de dados criado;

- Ao abrirmos o formulário, serão exibidas as linhas e colunas selecionadas, constantes no arquivo do Excel trazidas via ODBC;

- Ao adicionarmos dados às colunas da tabela do Excel e salvarmos, podemos retornar ao sistema e executar o gatilho novamente, as alterações serão refletidas no formulário de dados.

Ocorrerá erro caso haja alterações nas colunas existentes no arquivo do Excel, deve-se manter o mesmo nome no cabeçalho das colunas, assim como o número de colunas não deve ser alterado.

¶ 8. Como rodar uma carga via REST

- Dentro do arquivo de configuração do

DataLoadGatewayConfigserá necessário incluir uma nova entrada:

DataSourceName: "Data Load Rest",

DataSourceType: "DATALOADREST"

- DataSourceName: pode ser qualquer nome, desde que contenha o "rest" em sua composição;

- DataSourceType: DATALOADREST (deve ser este nome, não deve ser alterado);

¶ 9. Rodando o Client Gateway como serviço (Windows)

Os passos para registrar o Client Gateway como um serviço do Windows.

- Abra um terminal Windows com privilégios de administrador.

- No prompt de comando digite a seguinte sintaxe: sc.exe create NewService binpath= c:\windows\system32\NewServ.exe

- NewService: é o nome do serviço que você deseja criar;

- binpath: vamos atribuir o caminho completo de onde se encontra o executável do Client Gateway;

- Clique Enter na linha digitada.

- O novo serviço vai aparecer listado na tela de serviços do Windows.

O SC.exe tem outros parâmetros que podem ser usados na criação de um serviço. No passo a passo descrito acima, esses são os parâmetros mínimos obrigatórios para se registrar um serviço. Você pode saber mais sobre os outros parâmetros clicando no link: Microsoft Learn - SC.exe create

Para removermos o serviço criado, o comando é: sc delete ServiceName, onde ServiceName é o nome do serviço desejamos remover.

¶ 9.1. Identificação de Erro

Em alguns casos, pode ocorrer erro ao iniciar o serviço do windows, se isso vier a ocorrer, será necessário executarmos o Client Gateway através de um prompt de comando para identificarmos o erro.

Para isso, vamos seguir os seguintes passos:

- Abra o explorador de arquivos do Windows;

- Localize o local onde o executável do Client Gateway está salvo;

- Após localizar o local, ainda no explorador de arquivos, acesse o local do arquivo no terminal (clique com o botão direito Abrir no Terminal, ou, clicar no caminho exibido e digitar

cmd); - Ao realizar o passo anterior, o terminal será aberto no local do arquivo;

- Ao acessar o terminal no local do arquivo, vamos realizar o seguinte comando:

ClientGateway.exe;

Ao executar este passo a passo, estaremos executando o Client Gateway, e possivelmente veremos uma mensagem de erro que estará logada no terminal, com isso poderemos identificar o que está ocasionando o erro ao executar o Client Gateway como serviço do Windows.

¶ 10. Rodando o Client Gateway como serviço (Linux)

Após efetuarmos o download do arquivo do ClientGateway para Linux na seção 2.1 deste manual, precisaremos criar um serviço no diretório /etc/systemd/system/, que iremos nomear como ClientGateway.service.

- Vamos abrir um editor de texto com privilégios de superusuário;

- Podem ser utilizados editores como

nano,vi,vim. Neste manual iremos utilizar onano;

- Após abrir o editor, vamos executar o seguinte comando, para a criação do serviço:

sudo nano /etc/systemd/system/ClientGateway.service

- Vamos adicionar o conteúdo do arquivo de serviço:

# ClientGateway.service

[Unit]

Description=T6 Enterprise Client Gateway

[Service]

ExecStart=dotnet /home/azureuser/ClientGateway/ClientGateway.dll

SyslogIdentifier=T6ClientGateway

User=azureuser # Nome do usuário Linux que irá executar o serviço

Restart=always

RestartSec=5

[Install]

WantedBy=multi-user.target

- Após adicionar o conteúdo, vamos salvar (utilizando o

nanopodemos fazer isso pressionando CTRL + O); - Após concluir, podemos fechar o editor (utilizando o

nanopodemos fazer isso pressionando CTRL + X);

- Precisaremos habilitar e iniciar o serviço do ClientGateway;

- Para Habilitar o serviço, ainda no editor de texto, vamos executar o seguinte comando: sudo systemctl enable ClientGateway;

- Para iniciar o serviço, ainda no editor de texto, vamos executar o seguinte comando: sudo systemctl start ClientGateway;

Para garantirmos que o serviço está funcionando corretamente, podemos verificar o status dele realizando o seguinte comando: sudo systemctl status ClientGateway.

¶ 11. Carga de Dados Incremental

A carga de dados incremental faz a substituição dos dados da tabela no Banco de Dados, primeiro fazendo a exclusão dos dados, e depois, fazendo a inserção, conforme o período selecionado.

Para utilizar a carga de dados incremental vamos seguir os seguintes passos:

- Vamos criar um objeto do tipo processo do Workflow;

- Este processo deverá ter uma tarefa e esta tarefa deve conter 2 parâmetros do tipo Data, um indicando a data de início dos registros desejados e um indicando a data final dos registros selecionados. Para fins de exemplo, vamos nomeá-los como

StartDateeEndDate; (Para informações complementares sobre Workflow, Gatilhos e Parâmetros, acesse: Workflow BPM)

- Vamos inserir um nome qualquer para a tarefa;

- Em tipo da tarefa, vamos selecionar Carga de Dados Remota e clicar em próximo;

- Em Carga de Dados Remota, vamos selecionar o objeto de carga de dados remota criado anteriormente;

- Em Comando SQL, vamos inserir a chamada SQL que desejamos executar;

- Em Destino, vamos selecionar Novo;

- Quando selecionamos Novo em destino e o processo funciona, é criada a Tabela de Dados de acordo com o metadado;

- Vamos clicar em Finalizar, será criada uma Tabela de Dados com o nome da conexão criada no objeto de carga de dados remota;

Podemos selecionar em Destino uma tabela de dados já constante em nosso sistema, porém é necessário que o número de colunas e o nome em seus cabeçalhos sejam iguais ao da tabela de origem;

Podemos marcar a checkbox Reestruturar tabela de dados automaticamente que fará o ajuste automático da tabela de destino, sem a necessidade de ter o mesmo número e nome de colunas da tabela de origem;

- Vamos marcar a checkbox Carregamento Incremental;

- Para fazer o carregamento das colunas disponíveis de acordo com o comando SQL inserido acima, precisaremos clicar no

, sempre que o comando SQL for alterado, é necessário clicar no botão para recarregar as colunas disponíveis;

- No campo Nome da coluna com as datas iremos selecionar a coluna que usaremos como referência para a carga;

- Logo abaixo, teremos Parâmetro com a data inicial, onde iremos selecionar o parâmetro

StartDate, referente a data de início dos registros que queremos; - Em Parâmetro com a data final, onde iremos selecionar o parâmetro

EndDate, referente a data final dos registros selecionados;

Essas configurações vão definir somente os registros que serão deletados da tabela de destino, a parte de inserção vai depender do que for definido no comando SQL adicionado acima (caso faça somente o "SELECT", todos os registros serão carregados, independente da quantidade).

Exemplo do comando SQL aplicando os parâmetros:

SELECT * FROM REP_EXPLORER_OBJECT

WHERE

datModified >= COALESCE(NULLIF('Instance(StartDate)',"),'1970-01-01')

AND

datModified < COALESCE(NULLIF('Instance(EndDate)',"),'5000-01-01')

- No gatilho do processo, vamos definir nos parâmetros

StartDateeEndDate, com a data inicial e a data final, respectivamente; - Para finalizar, após inserir a data de início e a data final dos registros, vamos disparar o gatilho.

Sempre que for atualizada a versão do T6, é estritamente necessário atualizar a versão do Client Gateway.

¶ 12. Criação Dinâmica de Tabela de dados

Para utilizar a carga de dados para criação dinâmica da tabela de dados, vamos seguir os seguintes passos:

- Vamos criar um objeto do tipo processo do Workflow;

- Este processo deverá ser configurado com um parâmetro do tipo Texto para nomear a tabela de dados, vamos nomeá-lo como

TableName(Este parâmetro será utilizado no item 8. deste tópico); (Para informações complementares sobre Workflow, Gatilhos e Parâmetros, acesse: Workflow BPM)

- Vamos criar uma nova tarefa e definir um nome qualquer;

- Em tipo da tarefa, vamos selecionar Carga de Dados Remota e clicar em próximo;

- Em Carga de Dados Remota, vamos selecionar o objeto de carga de dados remota criado anteriormente;

- Em Comando SQL, vamos inserir a chamada SQL que desejamos executar;

- Em Destino, podemos selecionar qualquer opção disponível no dropdown (independente da tabela de dados selecionada em destino, somente vamos cria-la ao dispararmos o gatilho do processo);

- Vamos marcar a checkbox Reestruturar tabela de dados automaticamente que fará o ajuste automático da tabela de destino;

- Em Parâmetro para nome de tabela dinâmico: vamos selecionar o parâmetro do tipo texto criado anteriormente,

TableName;

- Quando a tarefa for executada, o valor inserido no parâmetro

TableNamedefinirá o nome da tabela de dados de destino.

Caso não conste nenhuma tabela de dados com o nome definido, a mesma será criada de forma dinâmica e salva na pasta Raiz do T6.

Atenção, caso exista alguma tabela de dados com o nome definido no parâmetro, a mesma terá seus dados sobrescritos;

-

Após concluir a configuração do processo, clique em Salvar e publique o cubo;

-

No gatilho do processo, vamos definir no parâmetro

TableNameo nome da tabela de dados de destino; -

Para finalizar, após inserir o valor no parâmetro, vamos disparar o gatilho.